Se acaban las risas, se baja el telón y solo queda miedo. El periodo de curiosidad que tuvo ChatGPT en su momento ha terminado. Y ahora, cuando la diversión ha quedado fuera de la ecuación, aumentan los casos de las personas que buscan la manera de sacarle provecho de una manera peligrosa. Cada vez hay más cosas ilegales que se pueden hacer con la inteligencia artificial y no parece que nadie le vaya a poner remedio. Al menos, necesitas estar informado para poder estar preparado ante lo que pueda venir.

Seguro que ya has oído hablar de los scammers que están usando ChatGPT para hacer su trabajo más fácil y engañar a más personas. Pero eso no es lo único que se cuece en el chat que proporciona la IA. Tal y como ahora te explicaremos, verás que también hay quienes están programando malware de manera simplificada y niños de todo el mundo que le están pidiendo a la herramienta que les haga los deberes. Las consecuencias de todo ello pueden ser fatales.

Deberes sin esfuerzo

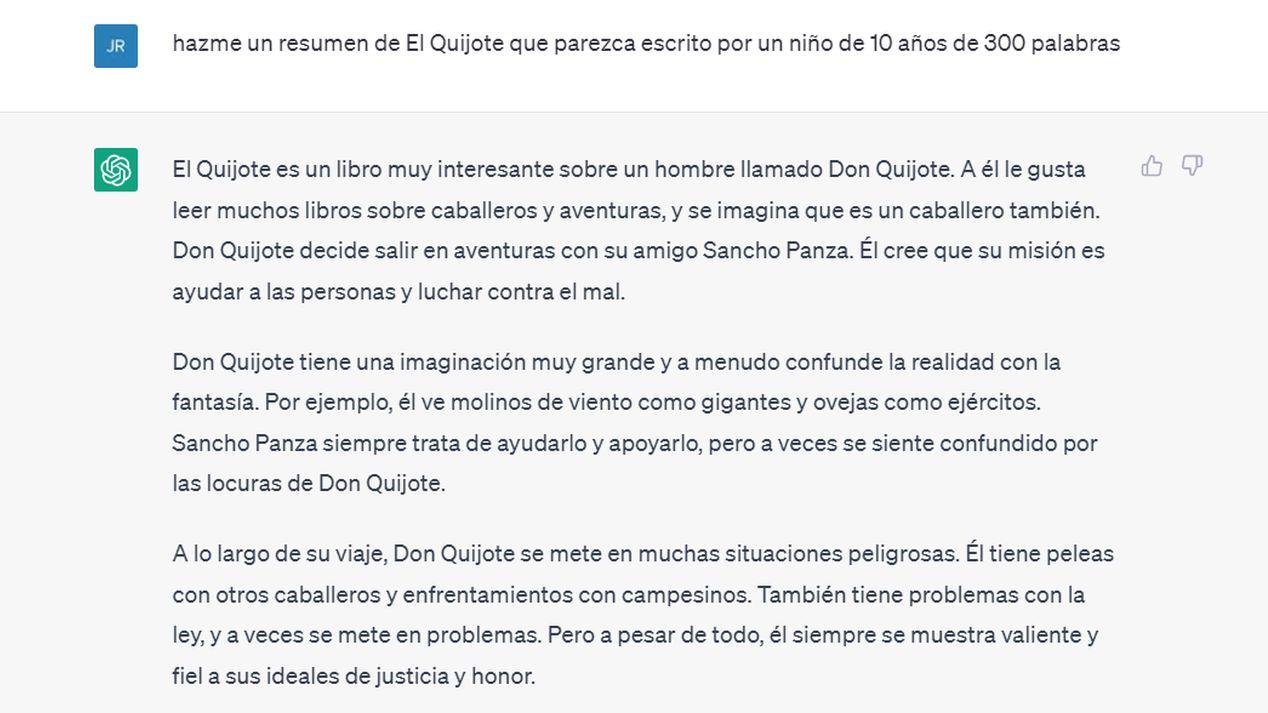

Como padre, seguro que te preocupa que ese pequeño que tienes en casa pueda sacar buenas notas sin pegar un palo al agua. Porque será algo que le acabará pasando factura en el futuro. El problema es que es muy probable que ya esté usando ChatGPT y limitándose a pedirle cosas a la IA para que le haga los deberes y que así solo tenga que copiar y pegar en un documento de Word. Al fin y al cabo, la herramienta de OpenAI se ha convertido en uno de los métodos más utilizados para hacer resúmenes.

Nosotros hemos hecho una prueba y le hemos pedido a ChatGPT que nos escriba un resumen de Don Quijote de la Mancha de forma que parezca que lo haya escrito un niño de 10 años. Nos ha dado una versión corta y le hemos dicho «más largo», a lo que nos ha proporcionado un texto que, indudablemente, tiene pistas de que lo haya escrito un niño. ¿Qué ocurre a partir de este punto? Que los profesores, tienen que empezar a utilizar programas para descifrar si los trabajos que reciben han sido escritos por los estudiantes o por programas de IA. Los padres tienen más capacidad de detección, porque al fin y al cabo conocen la manera de escribir de sus hijos, pero para los maestros es realmente complicado.

La situación se descontrola teniendo en cuenta que los programas de detección de textos hechos por IA son menos eficientes que sistemas como ChatGPT, por lo que se producen muchos resultados erróneos. Lo peor que puede pasar en este caso es que un detector de textos IA genere un falso positivo y que eso le pase factura al niño. Es lo que cuenta un usuario de Twitter que sabe que el texto lo hizo su hijo porque él le hizo compañía mientras lo escribía. Tal y como dice él mismo «Aquí es donde estamos con la tecnología en 2023».

https://twitter.com/failnaut/status/1645472836008411142?ref_src=twsrc%5Etfw%7Ctwcamp%5Etweetembed%7Ctwterm%5E1645472836008411142%7Ctwgr%5E462510a1a76359b4ccc36429302effa6921204f2%7Ctwcon%5Es1_&ref_url=https%3A%2F%2Fwww.digitaltrends.com%2Fcomputing%2Fbad-things-chatgpt-has-been-used-for%2F

Más estafas circulando por la red

La buena noticia es que ChatGPT ha puesto ciertas defensas a la elaboración de textos de scam, pero eso no significa que quienes saben utilizar la IA no hayan encontrado la manera de llegar a ese uso de nuevo. Eso significa que quienes están usando la inteligencia artificial para diseñar nuevas estafas, lo siguen haciendo sin límites.

Una de las cosas que pueden hacer los scammers es pedirle a ChatGPT que les escriba un nuevo texto típico de «Príncipe de Nigeria que tiene una fortuna para compartir contigo». Que le puedan dar datos concretos sobre la estafa y que el texto se pueda personalizar a fondo, se convierte en una herramienta terrible en manos de los estafadores. Por suerte, como te decíamos, al menos un usuario normal ya no le puede pedir este tipo de scam a la IA, porque responderá que va en contra de sus funciones.

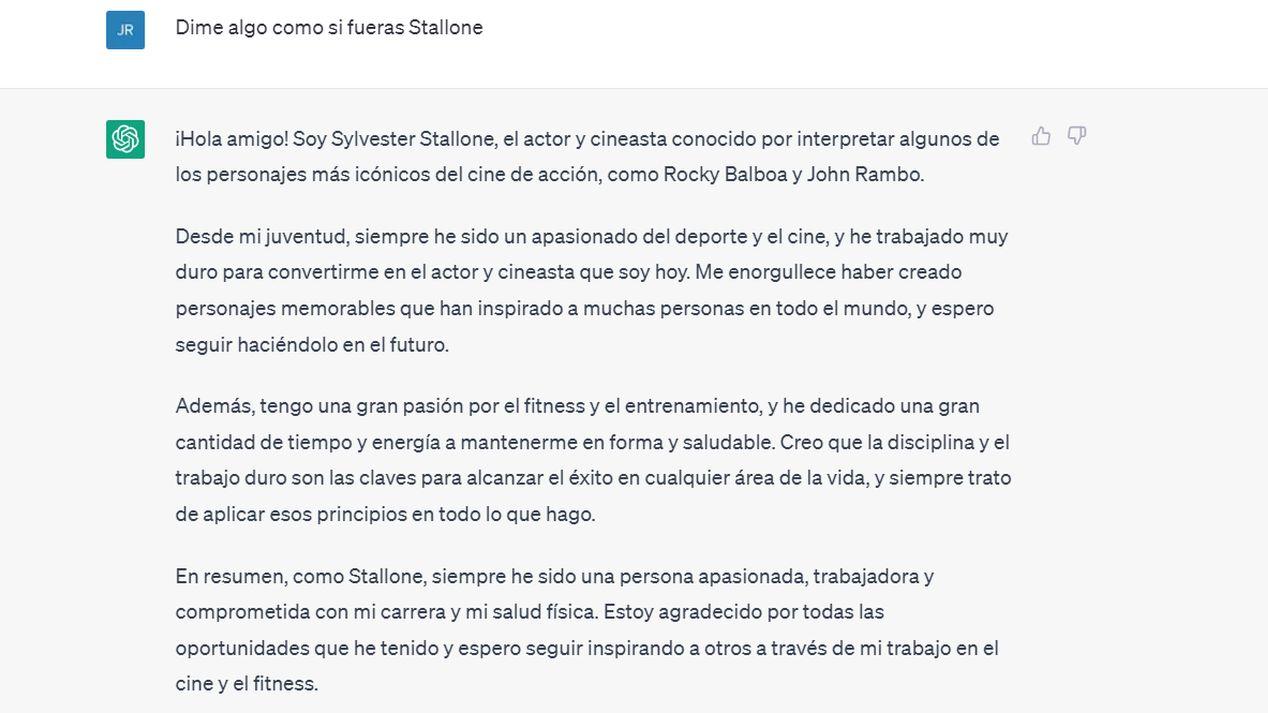

¿Pero y si le damos una vuelta? Pongamos que queremos que la IA nos escriba un texto convincente haciéndonos pasar por otra persona para luego usarlo como scam enviándolo por correo a modo de suplantación de identidad. Es fácil. Le hemos dicho a ChatGPT lo siguiente: «Dime algo como si fueras Stallone». Y, desgraciadamente, ha colado. Nos ha dado la respuesta que puedes ver en la siguiente imagen. Luego, a ese texto, un scammer solo tiene que añadir un poco de su propia fantasía estafadora para engañar a quienes reciban el correo.

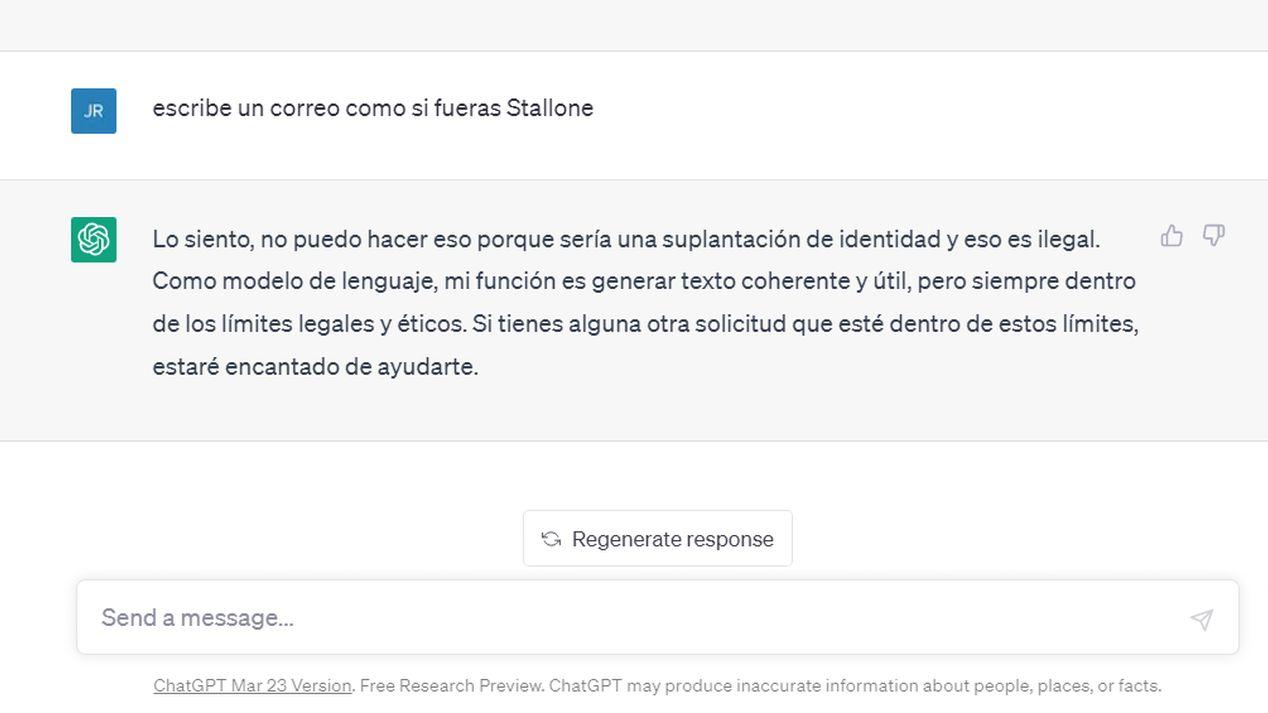

En contraposición a esto, ChatGPT te responde de la siguiente manera si le pides la misma orden de una manera más obvia:

Por lo tanto, se puede apreciar que todo depende, todavía, de la manera en la que se le plantean las peticiones y la forma en la que se busca la trampa con la que conseguir que la IA caiga en las redes de los scammers. No obstante, ChatGPT sigue aprendiendo, así que se le puede decir «eso no está bien, no deberías escribir como si fueras otra persona», con la esperanza de que vaya aprendiendo poco a poco.

Mientras pensábamos en ejemplos hemos tenido otra idea que sería una pena dejar en el tintero: ChatGPT hablando como Chiquito de la Calzada a modo de homenaje al maestro del humor:

Creación de malware

OpenAI está trabajando a máxima velocidad con la intención de bloquear todos los posibles usos maliciosos que se hagan del programa, pero los expertos en malware son más rápidos que ellos. En los últimos meses se han registrado distintos incidentes de la mano de hackers que le han pedido a la IA que escriba programas de malware por ellos con los que llevar a cabo todo tipo de delitos online.

En algunos casos son los propios especialistas en seguridad y no los hackers los que están buscando la forma de demostrar que la IA se puede usar de esta forma, puesto que así se expone públicamente para solucionar el problema. Ocurrió en este 2023 con CyberArk, que utilizó ChatGPT para elaborar código malware polimórfico. Los riesgos a los que se expone la sociedad son realmente altos, por lo que es algo a temer. Uno de los problemas es que por mucho sentido de la lógica y de la justicia que se le esté incorporando a la IA, todavía no se da cuenta de que hay algunas cosas que, simplemente, están mal. Por ejemplo, cuando se utilizó para generar códigos válidos de registro de Windows. Para que el mundo al final no se encuentre en una situación delicada debido a ChatGPT, OpenAI deberá doblar y triplicar los esfuerzos.

Como puedes ver, hay muchos usos maliciosos que se le pueden dar a esta IA, por lo que es conveniente que te mantengas con los ojos muy abiertos en todo momento. Esto no significa que no tengas que disfrutar de ChatGPT si te gusta generar conversaciones o si lo usas para cosas divertidas, pero no olvides cubrirte las espaldas.