AMD ha anunciado oficialmente el nuevo AMD FreeSync 2, que viene a mejorar a su predecesor ofreciendo compatibilidad con el HDR. El FreeSync actual permite que el monitor y la tarjeta gráfica AMD se sincroniza con nuestro monitor para evitar el tearing, que ocurre cuando el monitor muestra dos imágenes distintas al mismo tiempo en partes distintas de la pantalla, ocasionando que haya un corte entre ambas.

El FreeSync actual es la respuesta de AMD a NVIDIA, que utiliza G-Sync. La principal ventaja de la solución de AMD frente a la de NVIDIA es que la primera es abierta y cualquier fabricante puede implementarla mediante software en su monitor sin tener que pagar, mientras que los fabricantes que quieran incorporar G-Sync tienen que pagar a NVIDIA, encareciéndose los monitores entre 100 y 200 euros con respecto a los que utilizan FreeSync. Estas soluciones, además de eliminar las imágenes ‘cortadas’ que produce el tearing, no introducen ningún retraso en la imagen, el cual sí introduce la Sincronización Vertical tradicional.

AMD FreeSync 2 trae HDR al PC, y coexistirá con FreeSync

Tanto el primer FreeSync como su segunda versión coexistirán en el mercado. Esto es debido a que FreeSync 2 sólo incluirá la compatibilidad con contenido HDR para monitores diseñados con esta tecnología. Un monitor sin HDR no vería ninguna ventaja de utilizar AMD FreeSync 2.

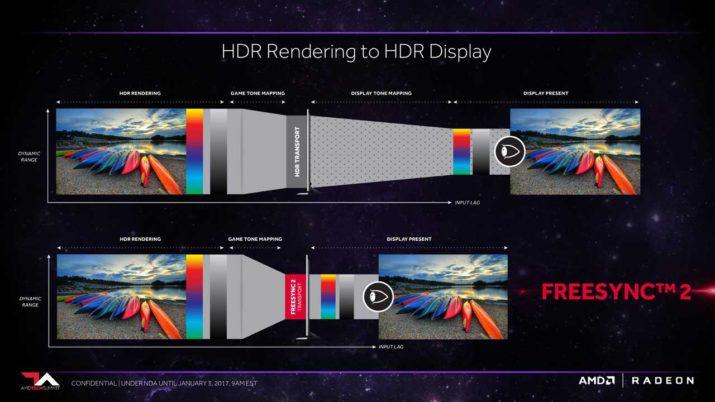

En la actualidad, el HDR de las televisiones introduce input lag, que puede llegar a ser superior a 100 ms debido a que la televisión tiene que procesar la imagen. En el consumo de contenido multimedia esto no supone un grave problema, pero para jugar es importantísimo tener el menor input lag posible. En los juegos para PC, el dispositivo que lee el juego procesa la imagen en HDR, y luego la pantalla la adapta al color que puede mostrar. Esto se debe a que es la televisión la que gestionar el aumento de carga que supone el HDR, y ocurre tanto en el estándar HDR10 que utiliza Amazon o Netflix como en Dolby Vision.

Disponible en la primera mitad del año

AMD ha diseñado FreeSync 2 con esto en mente, y es la tarjeta gráfica la que se encarga de procesar la información extra que se genera al haber una mayor profundidad de colores. De esta manera, el retraso desaparece. Todas las tarjetas tarjetas gráficas compatibles con FreeSync lo serán con FreeSync 2, por lo que no será necesario actualizar la tarjeta. Sólo será necesario actualizar los drivers de las tarjetas gráficas para hacerlos compatibles. Además, AMD está trabajando de manera conjunta con los desarrolladores de motores para juegos para que implementen de manera nativa el HDR en los juegos que desarrollen con esos motores.

Samsung será una de las primeras marcas en ofrecer compatibilidad con AMD FreeSync 2 en sus nuevas pantallas, y es ya conocida su gran apuesta por el HDR en sus televisores. Los primeros monitores con esta tecnología estarán disponibles en la primera mitad de este año, y AMD obliga a los fabricantes que lo implementen en sus pantallas un mínimo de color que sea el doble que el estándar sRGB.