El uso de la Inteligencia Artificial se está aplicando en multitud de usos, todavía con sus límites y limitaciones por definir. Una de las preocupaciones que pueden surgir, sobre todo en el caso de IA conversacional tipo ChatGPT es cuánto deben contar y cuánto deben callar… y esa línea roja parece que puede ser más clara de lo que creemos.

Hay un refrán que dice «valgo más por lo que callo, que por lo que hablo» y ese es precisamente el nuevo valor añadido que se quiere dar a una IA: que evite revelar secretos.

Cómo se evita que una IA comparta secretos

Tomemos como ejemplo el caso de Github, quienes han actualizado el modelo de IA de Copilot, un asistente de programación que genera código fuente en tiempo real y recomendaciones de funciones en Visual Studio, y afirman que ahora es más seguro y potente.

Para ello, el nuevo modelo de IA, que se lanzará a los usuarios esta semana, ofrece sugerencias de mejor calidad en menos tiempo, lo que mejora aún más la eficiencia de los desarrolladores de software al aumentar la tasa de aceptación. Copilot presentará con esta actualización un nuevo paradigma llamado «Fill-In-the-Middle», que utiliza una biblioteca de comandos de código conocidos y deja un espacio para que lo llene la herramienta de IA, logrando una mayor relevancia y coherencia con el resto del código del proyecto.

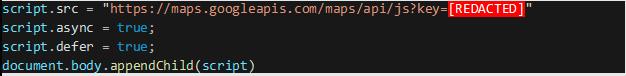

Una de las mejoras más destacadas en esta actualización de Copilot es la introducción de un nuevo sistema de filtrado de vulnerabilidades de seguridad que ayudará a identificar y bloquear sugerencias inseguras, como credenciales codificadas, inyecciones de ruta e inyecciones de SQL. La compañía de software dice que Copilot puede generar secretos como claves, credenciales y contraseñas que se ven en los datos de entrenamiento en cadenas novedosas. Sin embargo, estos no se pueden usar ya que son completamente ficticios y serán bloqueados por el nuevo sistema de filtrado.

Fuertes críticas por la revelación de secretos

La aparición de estos secretos en las sugerencias de código de Copilot ha provocado fuertes críticas por parte de la comunidad de desarrollo de software, y muchos acusan a Microsoft de usar grandes conjuntos de datos disponibles públicamente para entrenar sus modelos de IA sin tener en cuenta la seguridad, incluso incluyendo conjuntos que contienen secretos por error.

Al bloquear las sugerencias no seguras en el editor en tiempo real, GitHub también podría brindar cierta resistencia contra los ataques de conjuntos de datos envenenados que tienen como objetivo capacitar de manera encubierta a los asistentes de IA para que hagan sugerencias que contengan cargas maliciosas.

En este momento, los LLM (modelos amplios de aprendizaje) de Copilot aún se están capacitando para distinguir entre patrones de código vulnerables y no vulnerables, por lo que se espera que el rendimiento del modelo de IA en ese frente mejore gradualmente en el futuro cercano.