AMD anunció en el CES de 2019 la AMD Radeon VII, la primera tarjeta gaming del mercado con un chip de 7 nm. Hoy se han publicado las reviews que nos permiten conocer el rendimiento de la tarjeta y ver si realmente está a la altura de la NVIDIA RTX 2080. La tarjeta no ha sido enviada a medios españoles, por lo que hay que recurrir a extranjeros para conocer su rendimiento.

AMD Radeon VII: los 7 nm no sirven para que consuma menos, ya que han subido mucho la frecuencia

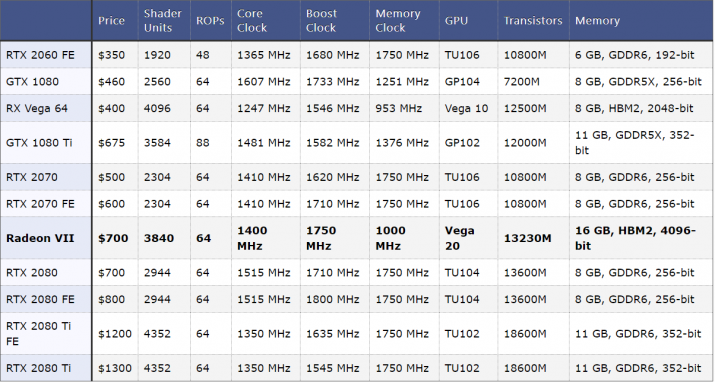

La premisa de la que partía AMD era bastante prometedora: una tarjeta gráfica con arquitectura Vega, pero fabricada en 7 nanómetros. Sus 16 GB de VRAM HBM2 quedan por delante de los 8 GDDR6 que ofrece la RTX 2080, y AMD quería mejorar el rendimiento de ésta al mismo precio. Pero no lo han conseguido.

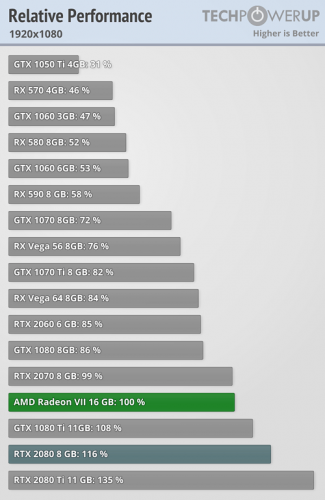

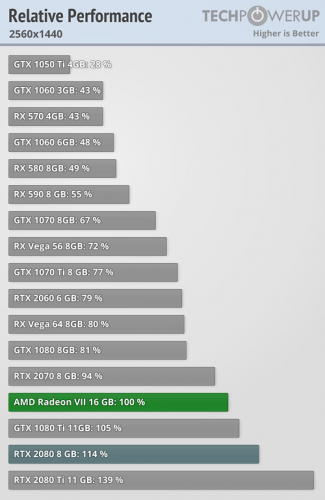

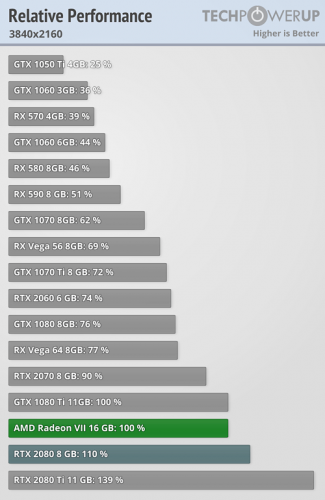

Como vemos en TechPowerUpy comentan nuestros compañeros de HardZone, los datos de rendimiento dejan bastante que desear. La tarjeta rinde casi como una RTX 2070 en 1080p, y queda muy lejos de la RTX 2080, que rinde un 16% mejor. En 1440p, la RTX 2080 rinde un 14%, y en 4K un 10%, donde la Radeon VII empata prácticamente con la GTX 1080 Ti, una tarjeta que ha podido llegar a comprarse por menos de los 755 euros a los que se han puesto a la venta algunos modelos en el día de hoy.

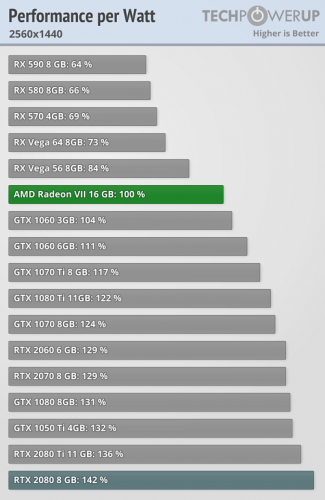

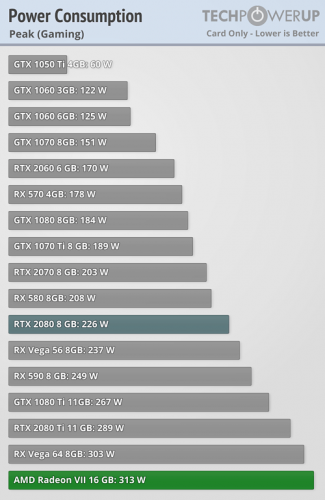

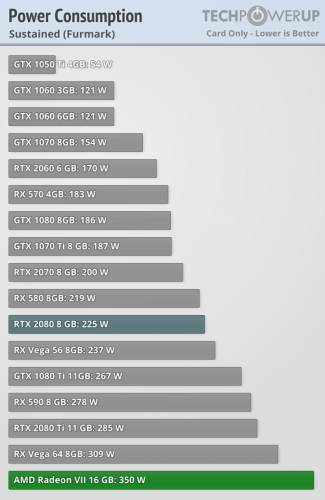

El consumo energético es algo superior al de la RTX 2080, y de hecho lo vemos en su doble conector de 8 pines que AMD ha preferido aumentar el consumo con tal de subir la frecuencia. Con ello, tenemos que las ventajas de pasar de 12 nm de las tarjetas de NVIDIA a 7 nm se esfuman, con un rendimiento por vatio paupérrimo. Además, el consumo es el mayor que encontramos en las tarjetas que hay actualmente a la venta, superando los 310 vatios de máximo jugando, y alcanzando los 350 vatios en tests sintéticos.

AMD podría haber hecho más por rebajar el precio de la tarjeta

AMD ha cogido básicamente la Radeon Instinct M50 para profesionales y le han puesto la etiqueta de gaming a la AMD Radeon VII. Su rendimiento en productividad es bueno, pero en juegos queda por detrás de lo esperado. Además, su memoria HBM2 es demasiado cara, llegando a suponer casi la mitad del coste total de la tarjeta (320 dólares) según se reveló hace unos días. Si le hubieran puesto 8 o 12 GB de VRAM y hubieran bajado la tarjeta unos 100 dólares de precio, estaríamos ante un interesante competidor.

Sin embargo, las funcionalidades extra de NVIDIA, además del soporte para Ray Tracing, DLSS y su completo software hacen que tengamos que esperar a Navi para ver si AMD puede plantar cara a NVIDIA aprovechando que son los únicos que lanzarán tarjetas de 7 nm este año. Hasta entonces, AMD seguirá sin hacer coincidir unos procesadores de lo mejor del mercado con las mejores tarjetas gráficas.