Google I/O presenta el Gemini más rápido hasta la fecha e incorpora la IA en todas sus apps

El mayor evento de Google ya ha llegado. Sigue con nosotros todas las novedades que la tecnológica tiene preparadas en este Google I/O 2024.

Hoy, 14 de mayo, es el día escogido por Google para dar a conocer todas las novedades que la compañía tiene preparadas para este año. Se trata de Google I / O 2024, la conferencia anual más importante de Google. Y que, además, también es una de las más esperadas en el ámbito tecnológico general.

Durante toda la presentación del evento hemos ido conociendo lo más interesante. Como no podía ser de otro modo, el ingrediente principal ha sido la Inteligencia Artificial. Que, como hemos podido comprobar, ha inundado la inmensa mayoría de las novedades que ha presentado hoy.

Sundar Pichai ha sido el encargado, como es habitual, de liderar la presentación. En este momento, comienza a dar un repaso a algunas de las principales innovaciones que han ido realizando durante los últimos meses. Todo con una clara orientación hacia la Inteligencia Artificial. Afirmando, además, que todavía nos encontramos en los primeros días de todo lo que la Inteligencia Artificial puede llegar a hacer.

Gemini IA

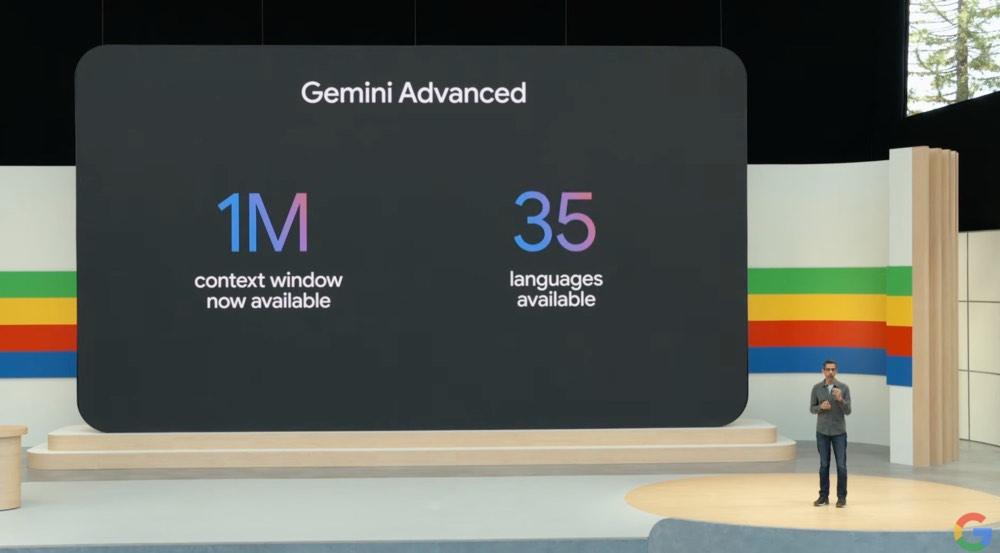

Una de las primeras cosas que ha mencionado es que Gemini es capaz de manejar hasta un millón de tókens en su versión de Gemini 1.5 Pro, recordando que su lanzamiento está cada vez más próximo.

Gemini va a incluir novedades en la aplicación Fotos de Google. El objetivo de vitaminarla para que pueda ser capaz de ofrecernos respuestas a cualquier pregunta que realizamos sobre las fotografías que tenemos en nuestro álbum. El ejemplo que ha publicado Google en el escenario permitía preguntarle a Gemini que nos enseñara una fotografía de nuestra matrícula de coche. Y, automáticamente, Gemini nos mostraba la fotografía en la que aparecía dicha información.

Gemini 1.5 Pro aterriza con diferentes novedades que van a permitir impactar de manera directa en la experiencia de usuario. Por ejemplo, va a mejorar de manera considerable todo lo que tiene que ver con la capacidad de razonamiento. Además, desde hoy mismo estará disponible para todos los desarrolladores, según han afirmado.

Gemini 1.5 Pro aterriza con diferentes novedades que van a permitir impactar de manera directa en la experiencia de usuario. Por ejemplo, va a mejorar de manera considerable todo lo que tiene que ver con la capacidad de razonamiento. Además, desde hoy mismo estará disponible para todos los desarrolladores, según han afirmado.

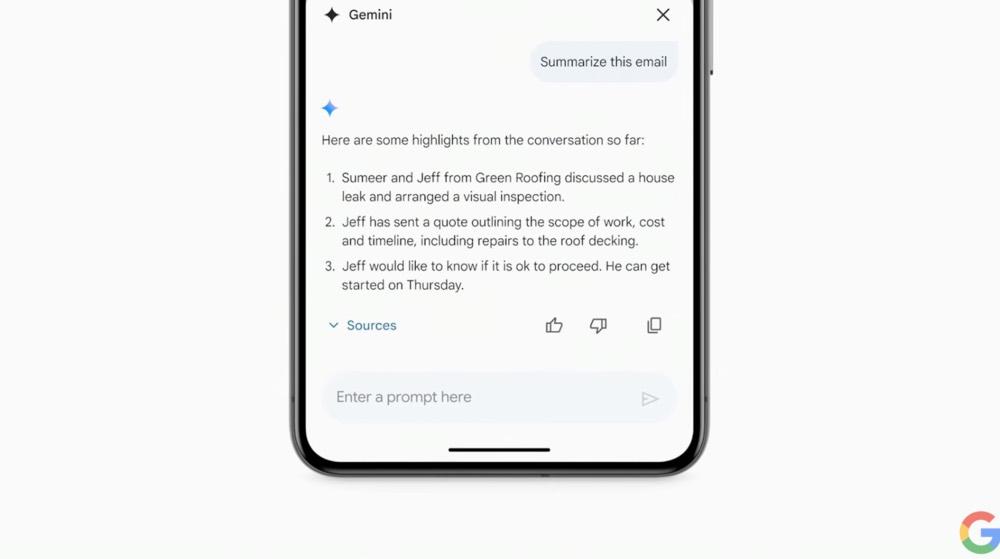

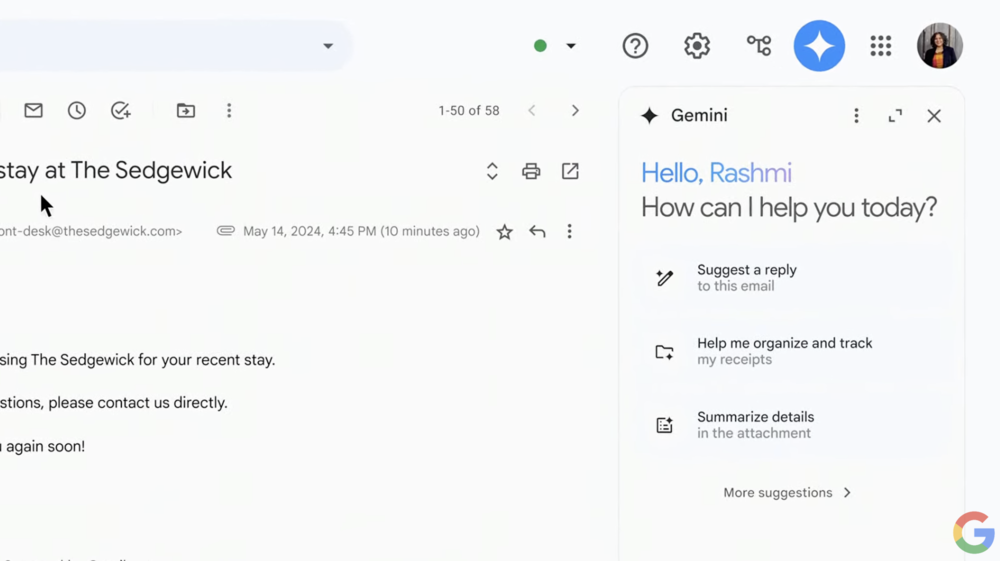

Además, su aterrizaje en Gmail para los usuarios de Google Workspace va a permitir que no tengamos que invertir tanto tiempo gestionando nuestra bandeja de correo. También se integrará en otras apps de la compañía.

En las reuniones con Google Meet, podremos pedirle que nos resuma los puntos más importantes de la reunión, sin necesidad de que tengamos que tomar ningún apunte.

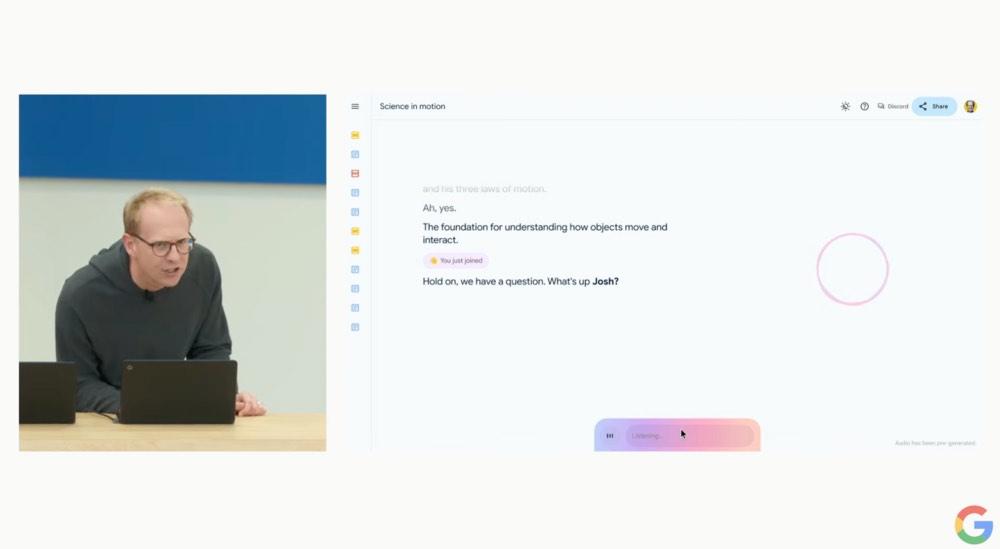

Seguimos explorando todas las opciones que nos va a brindar Gemini a tiempo real. A partir de ahora podremos analizar información o sintetizar los documentos con únicamente utilizar nuestra voz. No será necesario que tengamos que escribir, ni interactuar con el documento con nada que no sea la voz. Ha sido precisamente el desarrollo multimodal que ha incluido en sus modelos lo que ha permitido que no sea necesario tener que escribir para poder interactuar con ellos. Siendo únicamente necesaria la voz. Cuando se integre en Google Chrome, el funcionamiento va a ser muy similar. Simplificando de manera considerable el tiempo que pasamos en el navegador para realizar todo tipo de tareas.

Sundar Pichai se ha referido a los «agentes de la IA». Esta funcionalidad estará incluida en el ecosistema de apps de Google y nos permitirá realizar un seguimiento de nuestros pedidos de un modo muy sencillo. Se acabó para siempre perder la información de cualquier envío.

Google presenta Gemini 1.5 Flash con Demis Hassabis en el escenario. Se trata de un nuevo modelo que es mucho más ligero si lo comparamos con el modelo original. Está pensado para requerir de un menor consumo en términos energéticos, presentando igualmente grandes resultados.

Project Astra

Una de las principales novedadades llega de la mano de Project Astra. Se trata de un paso hacia delante en todo lo que tiene que ver con la información multimodal. Es capaz de ofrecernos información sobre nuestro entorno. Uno de los ejemplos que más ha llamado la atención es que encuentre unas gafas en una mesa o que detecte la raza de un perro.

Durante la presentación, la protagonista del vídeo ha utilizado unas gafas y ha podido interactuar con la Inteligencia Artificial. No era necesario que mirara el móvil para poder interactuar con su entorno.

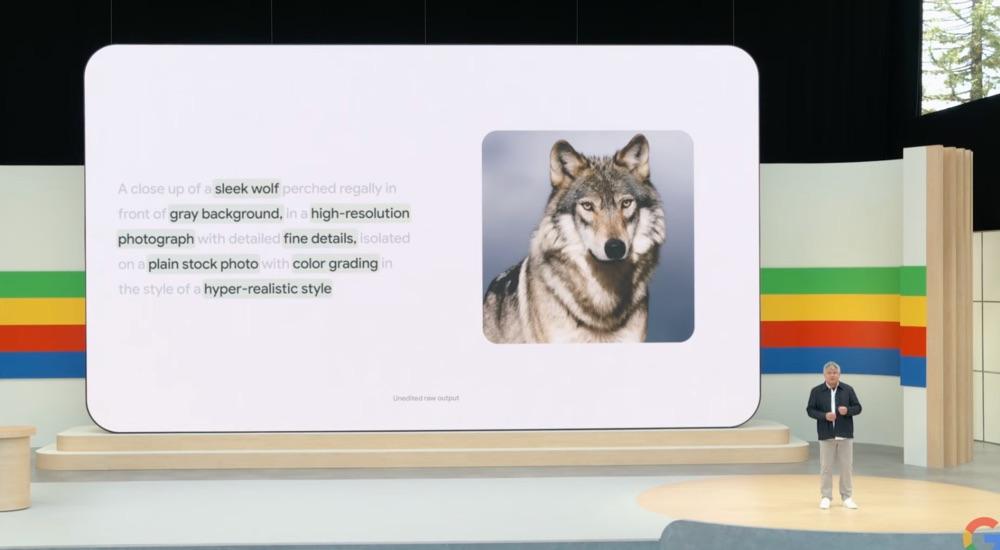

Es el momento de Imagen 3, otra de las grandes novedades. Se trata de un nuevo modelo de generación de imagenes que llega de la mano de Google. Es Doug Eck, el director de Google research, quién está en el escenario presentado las novedades que llegan al respecto. Vamos a poder crear contenido mucho más realista que, en esencia, tiene un gran parecido con las fotografías.

Google ha realizado un importante anuncio mientras presentaba este modelo. Y es que están trabajando con artistas de todo tipo de disciplinas para poder expandir su creatividad y conocer cómo pueden ayudarles a mejorar su flujo de trabajo.

VEO: la IA para vídeos

Google no ha dejado pasar la oportunidad de competir direcamente con Sora, la IA de OpenIA. Mediante «VEO», otra de las novedades de hoy, vamos a poder tener a nuestro alcance un nuevo modelo de creación y edición de vídeos que promete resultados espectaculares.

Con VEO vamos a poder crear vídeos a 1080p a partir de indicaciones que escribiremos en la herramienta. Además, tendremos la posibilidad de editar partes muy concretas de sus creaciones, sin necesidad de tener que repetir todo el vídeo.

Trillium: el chip de Google

Uno de los aspectos que más ha destacado Sundar Pichai es la demanda de potencia energética que requiere la IA. Y, por este motivo, la compañía americana ha lanzado Trillium. Se trata de un chip que permite a los centros de datos ofrecer una mejora que, en palabras de la compañia, puede mejorar 4,7 veces el rendimiento y la eficiencia energética a la que estamos acostumbrados actualmente.

También ha mencionado que el objetivo es continuar realizando inversiones para convertir a la refrigeración líquida en el estándar para poder proporcionar a los equipos informáticos de todo lo que necesitan.

Google Search

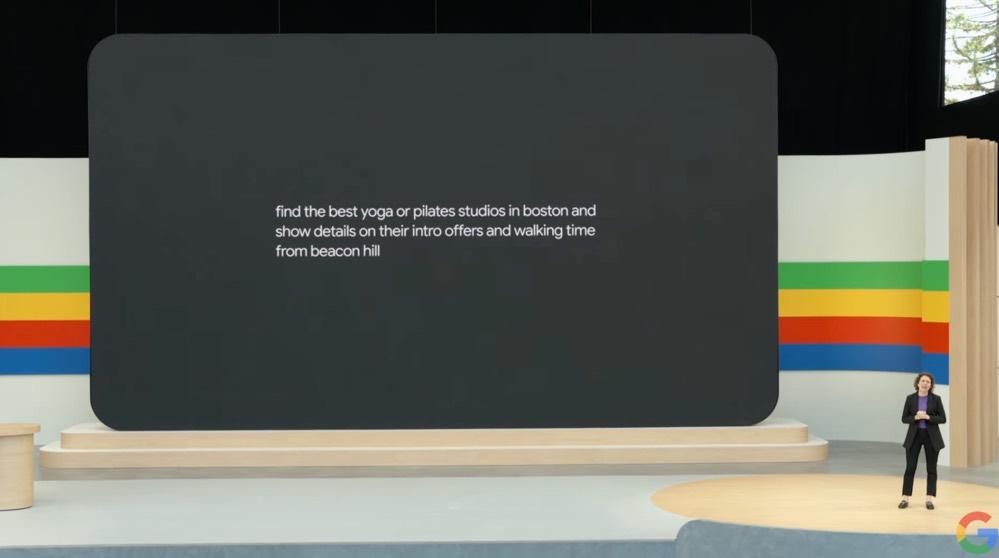

Es turno de Google Search. Ahora, han comenzado a explicar cuáles son las novedades de la Inteligencia Artificial aplicadas a Google Search. El aterrizaje de la IA en el buscador de Google supone un antes y un después en la forma de comportarse de la compañía.

El objetivo es que, de manera progresiva, el buscador de Google comience a hacer búsquedas por nosotros basándose en la lógica. Por ejemplo, al realizar una búsqueda para conocer los mejores sitios para practicar pilates, el propio buscador realizará las búsquedas oportunas, basándose en el contexto y en el historial de búsquedas, para mostrarnos únicamente aquellos espacios que realmente se adapten a nuestros gustos.

Google, ahora, va a poder crear un evento para nosotros. Únicamente tendremos que ofrecerle algo de información por nuestra parte para, por ejemplo, realizar una búsqueda de los locales en los que podemos llevar a cabo cualquier tipo de celebración o, incluso, prepararnos un menú con las propuestas gastronómicas.

Google también ha presentado una importante mejora en Google Lens. En el ejemplo, han grabado a un tocadiscos y le han preguntado a Google Search la razón por la que no funciona. Automáticamente, Google Search ha presentado una página con resultados basados en el contexto. Uno de los aspectos más sorprendentes es que, incluso, ha incluído el modelo concreto del tocadiscos. Realizando una lista con los problemas más típicos que presenta.

Gemini AI en las apps

Gmail, así como el resto de las apps del ecosistema de Google, se van a ver enriquecidas con la llegada de Gemini. En este caso, nos enseñan cómo las apps tendrán un icono de Gemini que nos ofrecerá la opción de, sin tener que leer los mails, resumir el mismo.

Una función que ya habíamos visto previamente, y que había sido fuente de múltiples rumores, pero que en la presentación se ve excepcionalmente bien.

Ahora, Google ha comenzado a presentar diferentes opciones que nos va a ofrecer la Inteligencia Artificial para interconectar apps de la propia Google. Para ello, va a poder obtener información de diferentes apps y reunirlas en un mismo panel que nos va a dar información sobre todo lo que estamos buscando. Toda la información quedará en un panel lateral que nos mostrará diferentes opciones adaptándose al contexto.

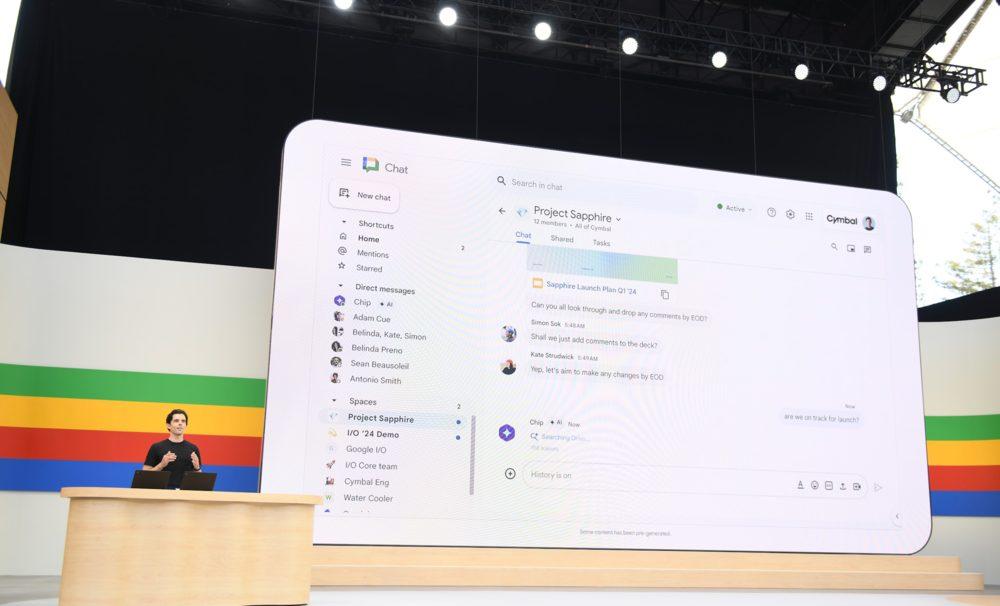

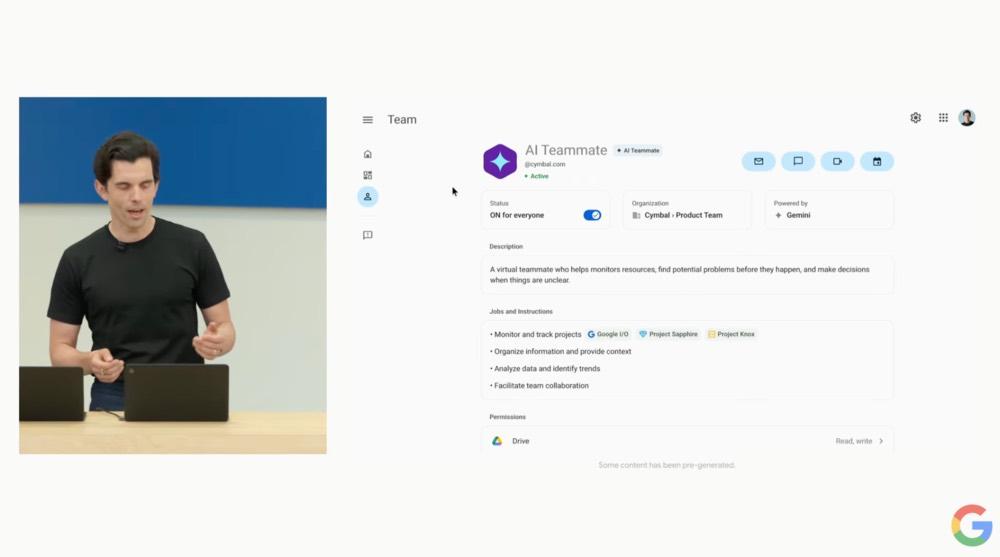

Otra función muy interesante llega de la mano de la posibilidad de interactuar con Gemini al mismo tiempo que estamos trabajando con otras personas. Esta función es bautizada como AI Teammate y, durante la presentación, hemos comprobado como los protagonistas iban lanzando preguntas al grupo de trabajo que tenían creados. No solo podían interactuar entre ellos, Gemini también daba sus propias respuestas. Como si fuera uno más. El asistente de Teammate tendrá el nombre de Chip.

La aplicación de Gemini Live estará disponible al final de este año. Con ella, podremos llevar a cabo conversaciones como si se tratara de una persona más. Incluso podremos interactuar con ella añadiendo soporte a tiempo real utilizando la cámara de nuestro smartphone con toda la información que puede recibir de nuestro alrededor.

Google no ha querido dejar pasar la oportunidad de introducir los «Gem». Se trata de un tipo de IA que estará especializado en un campo en concreto. Por ejemplo, el ejercicio físico. Con él, podremos obtener indicaciones, recomendaciones y todo tipo de información acerca de un campo concreto.

Según Google, Gemini tiene la ventana de información más grande del mundo, gracias a toda la información que ya contiene. Por lo que no puede tener rival en lo que hace referencia a la interpretación de datos.

Android

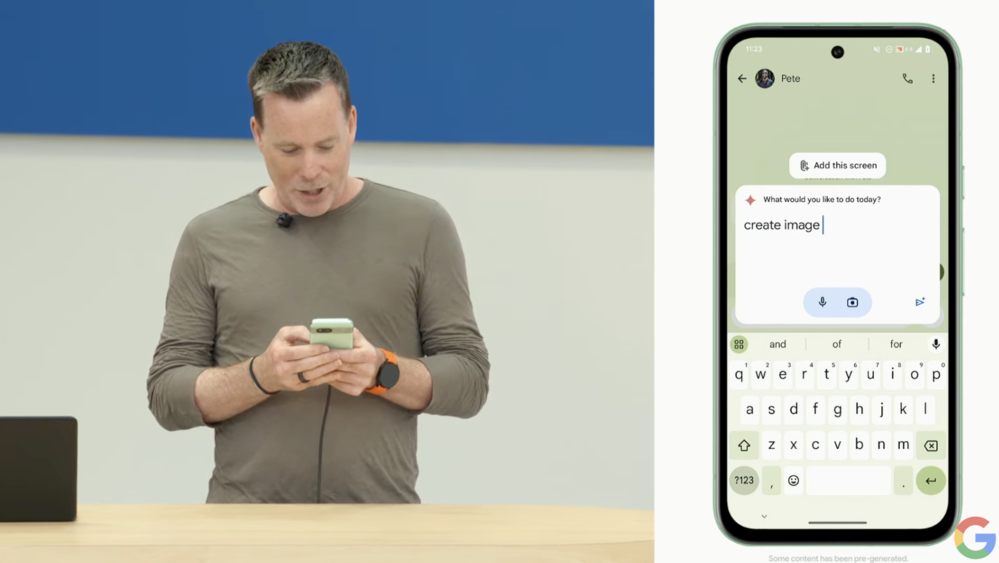

Es el turno de Android. Para Google, la llegada de la IA está cambiando por completo la forma en la que usamos nuestros smartphone. Como ya hemos visto recientemente, Google ha añadido diferentes opciones, como la posibilidad de dibujar un círculo para poder realizar una búsqueda. Una función que inicialmente llegó para los modelos Píxel. Y que, actualmente, también nos va a poder realizar operaciones matemáticas, por ejemplo.

Ahora, durante la demostración también se ha visto cómo el asistente va a entender el contexto que nos rodea para poder anticiparse a nuestras peticiones que realicemos sobre él. En esencia, Gemini va a poder realizar muchas cosas que ahora mismo ya realiza desde nuestro ordenador. Por ejemplo, extraer información de un documento PDF y contestarnos a todas nuestras preguntas. Incluso podremos realiazr consultas sobre un vídeo de YouTube que estemos visualizando en este momento.

Google ha presentado una novedad que es muy interesante. Más aún en un contexto como este, con las llamadas de spam convertidas en una realidad para muchos de nosotros. Ahora, si alguien está intentando estafarnos a través de una llamada, el propio smartphone nos avisará mediante una locución.

También se han presentado una serie de funcionalidades de Gemini Nano que aterrizan de manera directa en Android 15. Sin embargo, lo que más ha llamado la atención es que la beta 2 de Android 15 no estará disponible hoy, habrá que esperar a mañana.

Más novedades

Google Gemma, el conjunto de modelos de lenguaje abiertos de Google, también va a mejorar desde hoy mismo. Además, han anunciado la particularidad de que esta vez contamos con un modelo optimizado que nos permite interpretar imágenes y ha recibido el nombre de PaliGemma. En el mes de junio, los usuarios van a poder acceder a Gemma 2. Una nueva generación dispuesta a ofrecer un mejor rendimiento a todos sus usuarios.

Google también se ha detenido a hablar de de todo lo que tiene que ver con la privacidad y la seguridad de los usuarios. Para ello, ha presentado AI Assited Red Teaming, un conjunto de especialistas que garantizan la seguridad de los modelos de IA para que esta tecnología no pueda ser utilizada para aquellos fines que no sean los adecuados.

El anuncio de SynthID es otra de las grandes novedades. Se trata de una marca de agua que va a permitir que cualquier trabajo creado por IA pueda ser identificado. Siendo muy útil, por ejemplo, cuando se utilice la app de VEO que ha presentado previamente.