Actualmente, cuando compramos un televisor, un monitor, o un móvil, muchos fabricantes le están poniendo la etiqueta de HDR, o le incluyen un modo HDR a pesar de que no lo tienen real o nativo. Por ello, vamos a ver en qué tenemos que fijarnos para que la pantalla que compremos tenga HDR real. Vemos en prácticamente todas las pantallas y plataformas que publicitan HDR: en móviles, en tabletas, en televisiones, en Netflix, en Amazon Prime Video… Todos ofrecen esto pero, ¿cuál es real?

¿Hay monitores o pantallas con HDR real? Sí, por supuesto. Pero tenemos que fijarnos a la hora de comprarlo para que lo que nos ofrezcan sea esto. O, al menos, que sepamos diferenciar entre cuál es real o qué etiqueta nos permite una calidad parecida pero no similar.

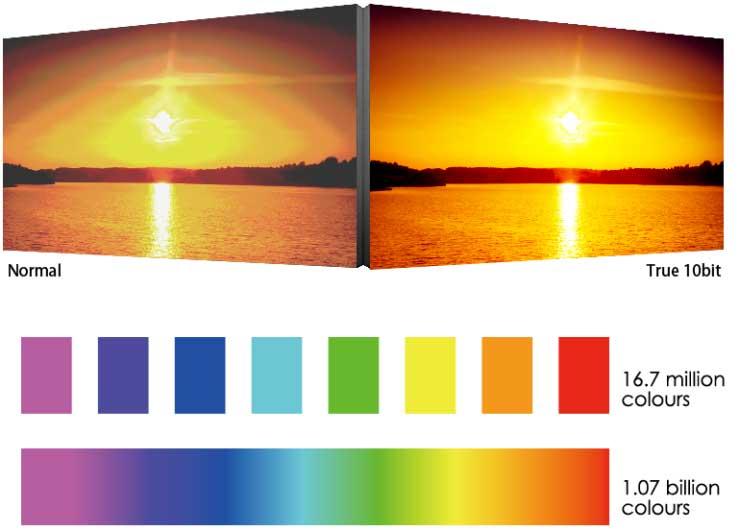

HDR, o High Dynamic Range, es como se ha llamado a la posibilidad de mostrar muchos más colores que hasta ahora. Una imagen SDR cuenta con 8 bits de profundidad de color, lo que equivale a 28 por subpíxel rojo, verde y azul. En total, tenemos que un píxel puede mostrar 16,77 millones de colores distintos. Con los paneles de 10 bits, esa cifra pasa a ser de 210, que equivale a 1.024 tonos distintos por subpíxel, o 1.073 millones de colores por cada píxel.

Estos paneles son mucho más precisos, y con las nuevas tecnologías, tienen una mayor luminosidad, pudiendo tener más tonos de negro y de blanco y ofreciendo imágenes más realistas. Para hacer eso es necesario tener local dimming para apagar las zonas más oscuras, ya que si se dispara el brillo en algunas zonas, los negros se ven con tonos grises. Sin embargo, hay muchos monitores o televisores que no tienen paneles de 10 bits, pero sí tienen algún modo o etiqueta de HDR o presumen de contar con esta tecnología.

Por tanto, el contrario de lo que muchos usuarios piensan, el HDR no va estrechamente relacionado con la resolución de un monitor o una televisión. Es decir, no exprime los píxeles de la pantalla para obtener unas imágenes con mejores contraste y mayor nitidez.

Actúa pues como un complemento que mejora la luz que se muestra en las imágenes y, de esta forma, ofrece al usuario una experiencia mucho más rica. Dicho de forma directa, es una tecnología de mejora de imagen.

Monitores: muchos ponen que tienen HDR pero en realidad no lo tienen

La mayoría de monitores del mercado de menos de 500 euros no llegan a los 400 cd/m2 de luminosidad, lo cual les impide cumplir con lo que pide el estándar DisplayHDR 400 para obtener la certificación. Por encima de esos precios, muchos monitores lo cumplen, pero siguen sin ofrecer HDR real que nos permita tener una mejora en la imagen tal y como la que esperamos.

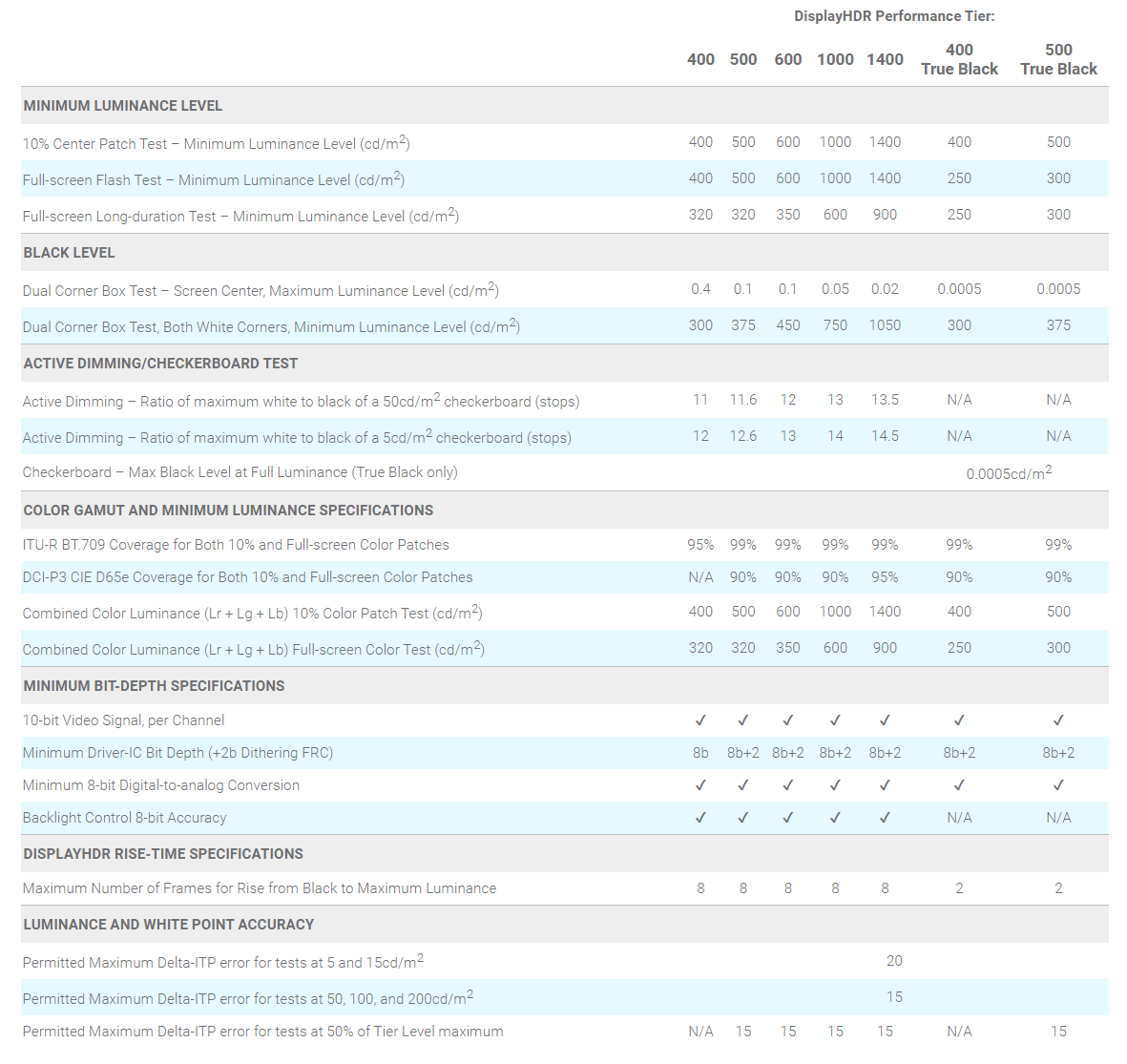

VESA actualizó el estándar DisplayHDR a la versión 1.1 en septiembre de 2019, obligando a que haya un dimming activo, a tener un mínimo de precisión de color, modos obligatorios en el menú que indiquen cuando el HDR está activo, etc. Además, añadieron una nueva categoría que se suma a DisplayHDR 400, 600 y 1000: la de 1400. Esta nueva categoría debe garantizar entre el 90 y el 95% de DCI-P3, además de guantar 900 nits de brillo en toda la pantalla durante periodos de larga duración (30 minutos). Los criterios ahora quedan de la siguiente manera:

Para activar la opción de HDR (llamado también WCG de Wide Color Gamut) en Windows 10 es necesario tener un monitor que realmente soporte la reproducción de contenido HDR10 a través de DisplayPort 1.4 o HDMI 2.0, además de una tarjeta gráfica compatible con PlayReady 3.0 y descodificación de contenido HEVC y los drivers WDDM 2.4 instalados. DisplayHDR 400 soporta HDR10, pero eso no indica que el monitor pueda mostrarlo, aunque sí reproducirlo.

Algunos monitores directamente están poniendo que tienen un “modo HDR”, que lo único que hace es disparar el contraste y la gamma para conseguir un de imágenes mucho más saturadas pero con peor calidad, y por supuesto sin acercarse ni un ápice al HDR real. Por ello, si vais a comprar un monitor para PC y queréis activar la función de HDR en Windows, aseguraos de que tenga la etiqueta de DisplayHDR; a ser posible superior a 600.

HDR y su importancia para el gaming

Conocida la teoría sobre qué es realmente el HDR, vamos a pasar a detallar por qué es importante especialmente para jugar a videojuegos. Y es que con este tipo de tecnología se consiguen algunas ventajas para hacer los títulos más realistas, especialmente el de aquellos más punteros.

El HDR muestra los colores mucho más similares a como nuestro ojo humano los percibe en el mundo real. Algo tan simple como poder ver un paisaje en un videojuego cuyo color sea igual a lo que vemos cuando paseamos por el campo, ya otorga una mayor sensación de realismo visual.

La iluminación es también importante. En los monitores HDR, hay parte de la pantalla que se activan con mayor o menor intensidad. Por ejemplo, la mejora en las escenas nocturnas u oscuras es bastante sustancial.

HDR G-Sync vs HDR FreeSync

Actualmente podemos encontrarnos con una amplia amalgama de contenidos catalogados con la etiqueta HDR, ya sea en plataformas digitales como en páginas web como YouTube. El uso en videojuegos, por ejemplo, es algo más reciente. Aunque se está introduciendo poco a poco, el uso del HDR parece más reservado al uso de monitores para el ámbito profesional. Como sabemos, se trata de dispositivos bastante caros.

Si hacemos referencia al mundo informático, dicha tecnología llega de la mano de las tecnologías de refresco adaptativo. En el caso de G-Sync, Nvidia utiliza un hardware determinado dentro del propio monitor para procesar la imagen. Por su parte, FreeSync hace lo propio directamente en la GPU. La diferencia aquí radica en el concepto que cada compañía tiene de lo que llamamos HDR.

Nvidia, por ejemplo, tiene unos requisitos muy estrictos con sus fabricantes de monitores. Para poder decir que sus tarjeta y productos son compatibles con la tecnología HDR, dicha compañía opta por una atenuación selectiva por toda la pantalla y utiliza cientos de LED. Como resultado, se obtiene un enorme contraste de colores y un brillo que puede llegar a situarse en torno a los 1.000 nits. Esta es la auténtica clave para poder hablar de HDR.

En el caso de AMD, los requisitos no resultan tan exigentes. Esta compañía es más laxa a la hora de hacer sus FreeSycn compatibles con un supuesto monitor HDR. Por ejemplo, acepta que sus paneles tengan 8 bits en lugar de 10. Esto ya, de arranque, supone un sacrificio en el número de tonalidades, resultando sensiblemente menor. Asimismo, se decanta por menos cantidad de LED. Así, nos encontramos como resultado con diferentes niveles de calidad de monitores HDR dependiendo de un modelo u otro.

Con los televisores pasa lo mismo

Ocurre lo mismo con los televisores que con los monitores o pantallas de ordenador. Es decir, para que un televisor reproduzca contenido en HDR es necesario que sea compatible con él de manera nativa. Es decir, que tenga un panel de 10 bits, ya sean 10 bits reales o de 8 bits que utilice FRC (Frame rate control), que permite emular esos 10 bits mediante la introducción de distintas tonalidades de colores en cada fotograma.

Sin embargo, no es lo mismo reproducirlo que mostrarlo, ya que para mostrarlo adecuadamente es necesario tener ese panel de 10 bits nativo, así como el local dimming que hemos mencionado antes para tener esa atenuación local que apague zonas de la pantalla. Un televisor que tiene un “modo HDR” pero no tiene local dimming utiliza el Edge LED para iluminarse, de tal manera que no puede apagar zonas del panel, y por ello si hay una zona muy blanca y se sube el brillo, la parte más oscura en lugar de negro mostrará gris. Hay algunos televisores Edge LED que sí muestran contenido HDR real, pero con un rendimiento peor que si tuvieran local dimming, como tienen por ejemplo las QLED de Samsung con el Quantum Dot.

Con los televisores OLED esto no ocurre, ya que como cada píxel tiene iluminación independiente; un local dimming llevado a la máximo expresión que hace que estos paneles tengan un contraste infinito. Por ello, todos los televisores OLED que veáis van a tener HDR real siempre y cuando esos píxeles tengan 10 bits de profundidad de color, lo cual tienen todos los modelos actuales del mercado porque las OLED están centradas en la gama alta actualmente.

Este es el problema de que televisores 4K de 400 y 500 euros tengan la etiqueta de HDR, ya que los modos que incluyen hacen que incluso el contenido se vea con peor calidad, y desaliente a muchos usuarios a comprar televisores compatibles con esta tecnología porque en sus pantallas las estén viendo peor.

Como ya hemos hecho en algunos artículos previos, la recomendación que hacemos es que comprobéis las especificaciones del televisor que queréis comprar en displayspecifications.com, donde tenéis que mirar dos cosas: que el televisor tenga Local Dimming, o Full-Array Local Dimming si hablamos de un televisor con panel LCD (como las QLED), un panel de 10 bits, compatibilidad con estándares HDR como HDR10, Dolby Vision o HLG, buenas cifras de reproducción de color (95% de DCI-P3 o más, por ejemplo), y un brillo máximo lo más alto posible que supere los 600 nits. Con todo esto nos aseguraremos de tener un televisor con HDR real, y no una reproducción de ese contenido emulada.